Hardware and Software is getting more and more available and usable for everyone: Both in terms of price and complexity. Thanks to that, a growing crowd of enthusiast is building electronic gizmos. It’s getting even more interesting if you connect sensors and apps through the almost everywhere available Internet.

Classic industries seem to understand that this is important. So, they gave it a name: Industry 4.0! This fourth phase of industrialization is about cyber physical systems (which implies connectivity). Although they understand the importance, they often do not know how to deal with it. Saying that I am not criticizing their business or their competence!

Nevertheless, Industry 4.0, Machine-to-Machine (M2M), Internet of Things (IoT) or whatever you like to call it (indeed, there are differences)… It’s not just about generating business value, it’s not about saving or earning money in the first place! It’s much more about creativity and finding (or creating) new needs! It’s about innovating. Well, even innovations must proof themselves based on revenue, but if you turn around the motivation, your subject reduces to a replaceable vehicle for sales.

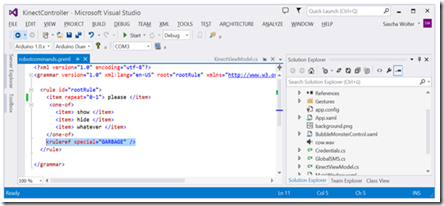

EtherNet/IP Sequence for I/O Data Transfer is public, but the protocol details cost a fortune (Source: ODVA – Open DeviceNet Vendor Association, Inc.)

One of the most important aspects about the Internet of Things movement is accessibility (in terms of availability and usability). Exactly that is missing talking about classic industries. For example, I wanted to use a specific sensor for the automation industry but finally gave up. I spend a decent amount of time, to get a specific sensor and even spend more time to use it. Well, it seemed so simple, because it’s just a basic socket connection. Unfortunately, it turned out the protocol itself isn’t that easy. Furthermore, you (in addition to the vendor) have to buy the specification or a library for a significant amount of money, too (which costs more than the sensor). It’s even worth, because some people did start open source libraries, but according to their websites had to stop for the sake of license issues.

The standards organizations and license owners have their arguments, like compatibility, security etc., but I simply don’t think that’s true: Security is literally a lame excuse for complex and obfuscated legacy systems. I think it’s just because of revenue! These people think, if a system performs just closed and/or complex enough, one might be willing to pay for it – and it’s even better if every party has to pay (the vendor and the customer). This is too shortsighted and only true as long as you do not have alternatives!

Anyway restricting the access to these technologies impedes innovation. If the opportunity costs are just too high, “innovators” will ignore these. Otherwise it takes frustrating long to experience and prove an idea! From my experience, this is even true doing workshops and prototypes together with these industries. This makes me sad, because it would be so easy for them, to implement interfaces for that, instead of remaining in stagnation…