Der „X-Y-Positions-Anzeiger für ein Bildschirmsystem“, kurz Maus, ist das Standardeingabegerät für grafische Benutzungsschnittstellen (GUI) geworden. Doch dabei kann mit der Maus weit mehr erreicht werden, als einfach nur das Ziehen und Klicken in Anwendungen. Die Kombination der verschiedenen Maustastenzustände und der Mausposition erlaubt ein Benutzererlebnis ähnlich zur Wii ganz ohne weitere Hardware (weiter unten mehr zur Wii).

Einfache Maus-Interaktionen wie Drücken, Bewegen und Loslassen der Maus ergeben in Kombination nicht nur Benutzereingaben wie „Drag and Drop“ sondern können auch als Geste für das Durchschneiden eines Objektes am Bildschirm dienen. Für die Flash-Welt liefert der Düsseldorfer David Ochmann unter http://davidochmann.de/#/info?p=462 eine Bibliothek namens DoGestures für ActionScript 2 und 3, die das Verwenden von Mausgesten erleichtert.

Einfache Maus-Interaktionen wie Drücken, Bewegen und Loslassen der Maus ergeben in Kombination nicht nur Benutzereingaben wie „Drag and Drop“ sondern können auch als Geste für das Durchschneiden eines Objektes am Bildschirm dienen. Für die Flash-Welt liefert der Düsseldorfer David Ochmann unter http://davidochmann.de/#/info?p=462 eine Bibliothek namens DoGestures für ActionScript 2 und 3, die das Verwenden von Mausgesten erleichtert.

Zur Nutzung von DoGesture in Flash muss dessen Klassenpfad erst einmal verfügbar gemacht werden. Dies geschieht über das Menü „Datei -> Einstellungen für das Veröffentlichen“, dann im Register Flash über die Einstellungen für ActionScript. Dort wird der Quellpfad hinzugefügt.

Als nächstes wird nur noch der folgende Code benötigt, um die Klassen per Import bekannt zu machen, die Geste zu erzeugen und auf deren Ereignis zu warten sowie eine passende Ereignisbehandlung durchzuführen:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

| // Mache Klassen verfügbar

import de.davidochmann.utilities.dogesture.DoGesture;

import de.davidochmann.utilities.dogesture.events.GestureEvent;

// Erzeuge Geste (der ausführliche Weg)

var movedown:DoGesture = new DoGesture(stage);

// Lausche dem Ereignis, dass die Geste stattfand

movedown.addEventListener(GestureEvent.GESTURE_COMPLETE, movedownCompleteHandler);

// Wie lange darf das Ausführen der Geste dauern

movedown.setTimeout(1000);

// Definiere die notwendigen Bewegungen für die Geste

movedown.add( 0, 50);

// Starte das Warten auf die Geste

movedown.start();

// Ereignismethode

function movedownCompleteHandler(e:GestureEvent):void

{

// Was soll nun passieren...

trace("Geste wurde durchgeführt!");

} |

// Mache Klassen verfügbar

import de.davidochmann.utilities.dogesture.DoGesture;

import de.davidochmann.utilities.dogesture.events.GestureEvent;

// Erzeuge Geste (der ausführliche Weg)

var movedown:DoGesture = new DoGesture(stage);

// Lausche dem Ereignis, dass die Geste stattfand

movedown.addEventListener(GestureEvent.GESTURE_COMPLETE, movedownCompleteHandler);

// Wie lange darf das Ausführen der Geste dauern

movedown.setTimeout(1000);

// Definiere die notwendigen Bewegungen für die Geste

movedown.add( 0, 50);

// Starte das Warten auf die Geste

movedown.start();

// Ereignismethode

function movedownCompleteHandler(e:GestureEvent):void

{

// Was soll nun passieren...

trace("Geste wurde durchgeführt!");

}

Microsoft Surface ist ein Tisch aus dem Jahre 2007. Er zeichnet sich durch eine berührungsempfindliche Oberfläche aus, der u. a. per Mulit-Touch und durch mehrere Nutzer gleichzeitig bedient werden kann.

Microsoft Surface ist ein Tisch aus dem Jahre 2007. Er zeichnet sich durch eine berührungsempfindliche Oberfläche aus, der u. a. per Mulit-Touch und durch mehrere Nutzer gleichzeitig bedient werden kann.

Der Maus droht seit ihrer Erfindung 1 963 durch Douglas C. Engelbart und William English Konkurrenz durch die Eingabe mit dem Finger oder anderen Körperteilen. Im Falle von Single-Touch, dient der eine Finger in der Tat auch meist eher als Mausersatz und das sogar mit ganz massiven Nachteilen: Der Finger verdeckt die Informationen am Bildschirm und führt bei der Arbeit an senkrechten Flächen zu schnell ermüdenden Armen – ähnlich wie bei der Arbeit an einer Schultafel führt.

Sobald mehrere Berührungspunkte möglich sind, lassen sich neue intuitive Gesten jenseits der Mausbedienung formulieren. Bekannt sind das Drehen und Skalieren von Inhalten mit zwei Fingern.

Silverlight bietet bereits seit Version 3 Multi-Touch. Dabei beschränkt sich Silverlight abhängig von der Abspielplattform auf die einzelnen Berührungspunkte. Gesten müssen selber erkannt und verarbeitet werden. Ein Beispiel inkl. Quellcode findet sich unter http://www.microsoft.com/downloads/details.aspx?displaylang=en&FamilyID=4b281bde-9b01-4890-b3d4-b3b45ca2c2e4.

Für eine einfache Touch-Anwednung in Silverlight benötigen wir ein beliebiges sichtbares Objekt, dass in diesem Beispiel mit monster benannt ist. Alles Weitere geschieht dann in der Code-Behind-Datei. Als erstes wird dort ein Transofrmations-Objekt für die Verschiebung des Monsters angelegt und das Ereignis für Berührungen angemeldet (Touch.FrameReported). In der Ereignismethode wird ab nun bei jedem Touch-Ereignis das Monster genau zu der Position der Berührung bewegt.

Für eine einfache Touch-Anwednung in Silverlight benötigen wir ein beliebiges sichtbares Objekt, dass in diesem Beispiel mit monster benannt ist. Alles Weitere geschieht dann in der Code-Behind-Datei. Als erstes wird dort ein Transofrmations-Objekt für die Verschiebung des Monsters angelegt und das Ereignis für Berührungen angemeldet (Touch.FrameReported). In der Ereignismethode wird ab nun bei jedem Touch-Ereignis das Monster genau zu der Position der Berührung bewegt.

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

| using System.Windows.Controls;

using System.Windows.Input;

using System.Windows.Media;

namespace SilverTouch

{

public partial class MainPage : UserControl

{

public MainPage()

{

// Required to initialize variables

InitializeComponent();

Loaded += new System.Windows.RoutedEventHandler(MainPage_Loaded);

}

private void MainPage_Loaded(object sender, System.Windows.RoutedEventArgs e)

{

// Erzeuge Transformationsobjekt für Verschiebung

CompositeTransform transform = new CompositeTransform();

monster.RenderTransform = transform;

// Lausche auf Touch-Ereignis

Touch.FrameReported += new System.Windows.Input.TouchFrameEventHandler(Touch_FrameReported);

}

private void Touch_FrameReported(object sender, System.Windows.Input.TouchFrameEventArgs e)

{

// Ermittle Tranformationsobjekt

CompositeTransform transform = monster.RenderTransform as CompositeTransform;

// Ermittle primären Berührungspunkt

TouchPoint tp = e.GetPrimaryTouchPoint(monster);

// Verschiebe Objekt zum Berührungspunkt

transform.TranslateX += tp.Position.X - (monster.ActualWidth / 2);

transform.TranslateY += tp.Position.Y - (monster.ActualHeight / 2);

}

}

} |

using System.Windows.Controls;

using System.Windows.Input;

using System.Windows.Media;

namespace SilverTouch

{

public partial class MainPage : UserControl

{

public MainPage()

{

// Required to initialize variables

InitializeComponent();

Loaded += new System.Windows.RoutedEventHandler(MainPage_Loaded);

}

private void MainPage_Loaded(object sender, System.Windows.RoutedEventArgs e)

{

// Erzeuge Transformationsobjekt für Verschiebung

CompositeTransform transform = new CompositeTransform();

monster.RenderTransform = transform;

// Lausche auf Touch-Ereignis

Touch.FrameReported += new System.Windows.Input.TouchFrameEventHandler(Touch_FrameReported);

}

private void Touch_FrameReported(object sender, System.Windows.Input.TouchFrameEventArgs e)

{

// Ermittle Tranformationsobjekt

CompositeTransform transform = monster.RenderTransform as CompositeTransform;

// Ermittle primären Berührungspunkt

TouchPoint tp = e.GetPrimaryTouchPoint(monster);

// Verschiebe Objekt zum Berührungspunkt

transform.TranslateX += tp.Position.X - (monster.ActualWidth / 2);

transform.TranslateY += tp.Position.Y - (monster.ActualHeight / 2);

}

}

}

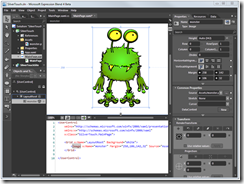

Auf dem Windows Phone Series 7 nutzt Silverlight für die Oberflächenelemente Manipulationsereignisse (u. a. ManipulationDelta). Diese teilen mit, inwiefern Skaliert oder Verschoben wurde. Um das Ereignis zu erhalten, kann in Expression Blend 4 oder Visual Studio 2010 bei einem Windows Phone Projekt ein Oberflächenelement mit einem Manipulationsereignis versehen werden.

Auf dem Windows Phone Series 7 nutzt Silverlight für die Oberflächenelemente Manipulationsereignisse (u. a. ManipulationDelta). Diese teilen mit, inwiefern Skaliert oder Verschoben wurde. Um das Ereignis zu erhalten, kann in Expression Blend 4 oder Visual Studio 2010 bei einem Windows Phone Projekt ein Oberflächenelement mit einem Manipulationsereignis versehen werden.

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

| <phoneNavigation:PhoneApplicationPage

x:Class="SilverPhone.MainPage"

xmlns="http://schemas.microsoft.com/winfx/2006/xaml/presentation"

xmlns:x="http://schemas.microsoft.com/winfx/2006/xaml"

xmlns:phoneNavigation="clr-namespace:Microsoft.Phone.Controls;assembly=Microsoft.Phone.Controls.Navigation"

xmlns:d="http://schemas.microsoft.com/expression/blend/2008"

xmlns:mc="http://schemas.openxmlformats.org/markup-compatibility/2006"

mc:Ignorable="d" d:DesignWidth="480" d:DesignHeight="800"

FontFamily="{StaticResource PhoneFontFamilyNormal}"

FontSize="{StaticResource PhoneFontSizeNormal}"

Foreground="{StaticResource PhoneForegroundBrush}">

<Grid x:Name="LayoutRoot" Background="{StaticResource PhoneBackgroundBrush}">

<Grid.RowDefinitions>

<RowDefinition Height="Auto"/>

<RowDefinition Height="*"/>

</Grid.RowDefinitions>

<!--TitleGrid is the name of the application and page title-->

<Grid x:Name="TitleGrid" Grid.Row="0">

<TextBlock x:Name="textBlockPageTitle" Style="{StaticResource PhoneTextPageTitle1Style}"><Run Text="MY "/><Run Text="TOUCH "/><Run Text="APPLICATION"/></TextBlock>

<TextBlock Text="touch me" x:Name="textBlockListTitle" Style="{StaticResource PhoneTextPageTitle2Style}"/>

</Grid>

<Grid x:Name="ContentGrid" Grid.Row="1">

<Image x:Name="monster" ManipulationDelta="Main_ManipulationDelta" Source="Assets/monster.png" HorizontalAlignment="Center" VerticalAlignment="Center" Width="240" Height="342"/>

</Grid>

</Grid>

</phoneNavigation:PhoneApplicationPage> |

<phoneNavigation:PhoneApplicationPage

x:Class="SilverPhone.MainPage"

xmlns="http://schemas.microsoft.com/winfx/2006/xaml/presentation"

xmlns:x="http://schemas.microsoft.com/winfx/2006/xaml"

xmlns:phoneNavigation="clr-namespace:Microsoft.Phone.Controls;assembly=Microsoft.Phone.Controls.Navigation"

xmlns:d="http://schemas.microsoft.com/expression/blend/2008"

xmlns:mc="http://schemas.openxmlformats.org/markup-compatibility/2006"

mc:Ignorable="d" d:DesignWidth="480" d:DesignHeight="800"

FontFamily="{StaticResource PhoneFontFamilyNormal}"

FontSize="{StaticResource PhoneFontSizeNormal}"

Foreground="{StaticResource PhoneForegroundBrush}">

<Grid x:Name="LayoutRoot" Background="{StaticResource PhoneBackgroundBrush}">

<Grid.RowDefinitions>

<RowDefinition Height="Auto"/>

<RowDefinition Height="*"/>

</Grid.RowDefinitions>

<!--TitleGrid is the name of the application and page title-->

<Grid x:Name="TitleGrid" Grid.Row="0">

<TextBlock x:Name="textBlockPageTitle" Style="{StaticResource PhoneTextPageTitle1Style}"><Run Text="MY "/><Run Text="TOUCH "/><Run Text="APPLICATION"/></TextBlock>

<TextBlock Text="touch me" x:Name="textBlockListTitle" Style="{StaticResource PhoneTextPageTitle2Style}"/>

</Grid>

<Grid x:Name="ContentGrid" Grid.Row="1">

<Image x:Name="monster" ManipulationDelta="Main_ManipulationDelta" Source="Assets/monster.png" HorizontalAlignment="Center" VerticalAlignment="Center" Width="240" Height="342"/>

</Grid>

</Grid>

</phoneNavigation:PhoneApplicationPage>

In der zugehörigen Code-Behind-Datei muss dann zum einen ein Tranformationsobjekt für eine Skalierung oder Verschiebung angelegt und in der Ereignismethode für das Manipulationsereignis eine Transformation durchgeführt werden.

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

| using System.Windows.Input;

using System.Windows.Media;

using Microsoft.Phone.Controls;

namespace SilverPhone

{

public partial class MainPage : PhoneApplicationPage

{

public MainPage()

{

// Required to initialize variables

InitializeComponent();

Loaded += new System.Windows.RoutedEventHandler(MainPage_Loaded);

}

private void MainPage_Loaded(object sender, System.Windows.RoutedEventArgs e)

{

// Erzeuge Transformationsobjekt für Verschiebung

CompositeTransform transform = new CompositeTransform();

monster.RenderTransform = transform;

}

// Ereignismethode

private void Main_ManipulationDelta(object sender, ManipulationDeltaEventArgs e)

{

// Ermittle Tranformationsobjekt

CompositeTransform transform = monster.RenderTransform as CompositeTransform;

// Verschiebe Objekt bzgl. der durchgeführten Manipulation

transform.TranslateX += e.DeltaManipulation.Translation.X;

transform.TranslateY += e.DeltaManipulation.Translation.Y;

}

}

} |

using System.Windows.Input;

using System.Windows.Media;

using Microsoft.Phone.Controls;

namespace SilverPhone

{

public partial class MainPage : PhoneApplicationPage

{

public MainPage()

{

// Required to initialize variables

InitializeComponent();

Loaded += new System.Windows.RoutedEventHandler(MainPage_Loaded);

}

private void MainPage_Loaded(object sender, System.Windows.RoutedEventArgs e)

{

// Erzeuge Transformationsobjekt für Verschiebung

CompositeTransform transform = new CompositeTransform();

monster.RenderTransform = transform;

}

// Ereignismethode

private void Main_ManipulationDelta(object sender, ManipulationDeltaEventArgs e)

{

// Ermittle Tranformationsobjekt

CompositeTransform transform = monster.RenderTransform as CompositeTransform;

// Verschiebe Objekt bzgl. der durchgeführten Manipulation

transform.TranslateX += e.DeltaManipulation.Translation.X;

transform.TranslateY += e.DeltaManipulation.Translation.Y;

}

}

}

Für Flash griff man bisher auf Zusatzprogramme zurück, die die notwendigen Daten – meist per TUIO (http://www.tuio.org/) – direkt an Flash übermittelten. Mit Flash Player 10.1 und AIR 2 hält Multi-Touch nun aber auch Einzug in die Flash-Welt. Abhängig von der Abspielplattform verstehen Flash und AIR einzelne Berührungspunkte und Gesten (gerade unter Mac OS ist das noch recht eingeschränkt, siehe auch http://www.adobe.com/devnet/flash/articles/multitouch_gestures.html).

1

2

3

4

5

6

| if (!Multitouch.supportsGestureEvents) {

Alert.show("Gesten werden nicht unterstützt", "Hinweis");

} else {

// Stelle sicher, Gesten zu nutzen

Multitouch.inputMode = MultitouchInputMode.GESTURE;

} |

if (!Multitouch.supportsGestureEvents) {

Alert.show("Gesten werden nicht unterstützt", "Hinweis");

} else {

// Stelle sicher, Gesten zu nutzen

Multitouch.inputMode = MultitouchInputMode.GESTURE;

}

Je nach Plattform werden unterschiedliche Gesten unterstützt (Multitouch.supportedGestures). Diese müssten sonst selbst aus den Berührungspunkten ermittelt werden.

Mit dem Flex 4 SDK und AIR 2 kann jedes interaktive Oberflächenelement Gesten nutzen. In den zugehörigen Ereignismethoden werden dann abschließend die Werte der Gesten verwendet.

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

| <?xml version="1.0" encoding="utf-8"?>

<s:WindowedApplication xmlns:fx="http://ns.adobe.com/mxml/2009"

xmlns:s="library://ns.adobe.com/flex/spark"

xmlns:mx="library://ns.adobe.com/flex/mx"

creationComplete="windowedapplication_creationCompleteHandler(event)">

<fx:Script>

<![CDATA[

import mx.controls.Alert;

import mx.events.FlexEvent;

protected function windowedapplication_creationCompleteHandler(event:FlexEvent):void

{

if (!Multitouch.supportsGestureEvents) {

Alert.show("Gesten werden nicht unterstützt!", "Hinweis");

} else {

// Stelle sicher, Gesten zu nutzen

Multitouch.inputMode = MultitouchInputMode.GESTURE;

}

}

protected function image_gestureZoomHandler(event:TransformGestureEvent):void

{

// Skaliere Objekt

(event.currentTarget as InteractiveObject).scaleX *= event.scaleX;

(event.currentTarget as InteractiveObject).scaleY *= event.scaleY;

}

protected function image_gesturePanHandler(event:TransformGestureEvent):void

{

// Verschiebe Objekt

(event.currentTarget as InteractiveObject).x += event.offsetX;

(event.currentTarget as InteractiveObject).y += event.offsetY;

}

protected function image_gestureRotateHandler(event:TransformGestureEvent):void

{

// Drehe Objekt

(event.currentTarget as InteractiveObject).rotation += event.rotation;

}

]]>

</fx:Script>

<mx:Image x="20" y="20" source="assets/monster.png"

gesturePan="image_gesturePanHandler(event)"

gestureZoom="image_gestureZoomHandler(event)"

gestureRotate="image_gestureRotateHandler(event)"

/>

</s:WindowedApplication> |

<?xml version="1.0" encoding="utf-8"?>

<s:WindowedApplication xmlns:fx="http://ns.adobe.com/mxml/2009"

xmlns:s="library://ns.adobe.com/flex/spark"

xmlns:mx="library://ns.adobe.com/flex/mx"

creationComplete="windowedapplication_creationCompleteHandler(event)">

<fx:Script>

<![CDATA[

import mx.controls.Alert;

import mx.events.FlexEvent;

protected function windowedapplication_creationCompleteHandler(event:FlexEvent):void

{

if (!Multitouch.supportsGestureEvents) {

Alert.show("Gesten werden nicht unterstützt!", "Hinweis");

} else {

// Stelle sicher, Gesten zu nutzen

Multitouch.inputMode = MultitouchInputMode.GESTURE;

}

}

protected function image_gestureZoomHandler(event:TransformGestureEvent):void

{

// Skaliere Objekt

(event.currentTarget as InteractiveObject).scaleX *= event.scaleX;

(event.currentTarget as InteractiveObject).scaleY *= event.scaleY;

}

protected function image_gesturePanHandler(event:TransformGestureEvent):void

{

// Verschiebe Objekt

(event.currentTarget as InteractiveObject).x += event.offsetX;

(event.currentTarget as InteractiveObject).y += event.offsetY;

}

protected function image_gestureRotateHandler(event:TransformGestureEvent):void

{

// Drehe Objekt

(event.currentTarget as InteractiveObject).rotation += event.rotation;

}

]]>

</fx:Script>

<mx:Image x="20" y="20" source="assets/monster.png"

gesturePan="image_gesturePanHandler(event)"

gestureZoom="image_gestureZoomHandler(event)"

gestureRotate="image_gestureRotateHandler(event)"

/>

</s:WindowedApplication>

Silverlight bietet seit Version 2 mit dem InkPresenter eine weitere Eingabemöglichkeit: Diesmal mit dem Stift. Der InkPresenter zeichnet die einzelnen Punkte der Stift- oder Mausbewegung auf. Sofern verfügbar sogar drucksensitiv.

Silverlight bietet seit Version 2 mit dem InkPresenter eine weitere Eingabemöglichkeit: Diesmal mit dem Stift. Der InkPresenter zeichnet die einzelnen Punkte der Stift- oder Mausbewegung auf. Sofern verfügbar sogar drucksensitiv.

In Expression Blend (oder auch mit Visual Studio) fügen Sie das Steuerlement InkPresenter ein und geben diesem einen Hintergrund (Background) hinzu, da andernfalls keine Eingaben erkannt werden. Klar, dass natürlich auch die Größen- und Positionsangaben passen müssen – in diesem Beispiel sind keine expliziten Angaben vorgenommen worden, da auf diese Weise die komplette Fläche ausgefüllt wird. Für die eigentliche Aufzeichnung der Stifteingabe nutzen wir das Drücken der linken Maustaste (MouseLeftButtonDown), das Bewegen der Maus (MouseMove) und die Nachricht, wenn der Bezug zur Maus wieder verloren wird (LostMouseCapture). Die zugehörigen Ereignismethoden landen in der zugehörigen Code-Behind-Datei:

In Expression Blend (oder auch mit Visual Studio) fügen Sie das Steuerlement InkPresenter ein und geben diesem einen Hintergrund (Background) hinzu, da andernfalls keine Eingaben erkannt werden. Klar, dass natürlich auch die Größen- und Positionsangaben passen müssen – in diesem Beispiel sind keine expliziten Angaben vorgenommen worden, da auf diese Weise die komplette Fläche ausgefüllt wird. Für die eigentliche Aufzeichnung der Stifteingabe nutzen wir das Drücken der linken Maustaste (MouseLeftButtonDown), das Bewegen der Maus (MouseMove) und die Nachricht, wenn der Bezug zur Maus wieder verloren wird (LostMouseCapture). Die zugehörigen Ereignismethoden landen in der zugehörigen Code-Behind-Datei:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

| using System;

using System.Windows;

using System.Windows.Controls;

using System.Windows.Documents;

using System.Windows.Ink;

using System.Windows.Input;

using System.Windows.Media;

using System.Windows.Media.Animation;

using System.Windows.Shapes;

namespace SilverPen

{

public partial class MainPage : UserControl

{

private Stroke currentStroke;

public MainPage()

{

// Required to initialize variables

InitializeComponent();

}

private void inkPresenter_MouseLeftButtonDown(object sender, System.Windows.Input.MouseButtonEventArgs e)

{

// Starte mit der Aufzeichnung

inkPresenter.CaptureMouse();

// Merke die Punkte

StylusPointCollection stylusPointCollection = new StylusPointCollection();

// Füge die ersten Punkte hinzu

stylusPointCollection.Add(e.StylusDevice.GetStylusPoints(inkPresenter));

// Erstelle aus den Punkten einen Strich

currentStroke = new Stroke(stylusPointCollection);

// Zeichne den Strich (dieser wird später weiter aktualisiert)

inkPresenter.Strokes.Add(currentStroke);

}

private void inkPresenter_LostMouseCapture(object sender, System.Windows.Input.MouseEventArgs e)

{

// Beende die Aufzeichnung

currentStroke = null;

inkPresenter.ReleaseMouseCapture();

}

private void inkPresenter_MouseMove(object sender, System.Windows.Input.MouseEventArgs e)

{

// Füge dem aktuellen Strich neue Punkte hinzu

if (currentStroke != null) {

currentStroke.StylusPoints.Add(e.StylusDevice.GetStylusPoints(inkPresenter));

}

}

}

} |

using System;

using System.Windows;

using System.Windows.Controls;

using System.Windows.Documents;

using System.Windows.Ink;

using System.Windows.Input;

using System.Windows.Media;

using System.Windows.Media.Animation;

using System.Windows.Shapes;

namespace SilverPen

{

public partial class MainPage : UserControl

{

private Stroke currentStroke;

public MainPage()

{

// Required to initialize variables

InitializeComponent();

}

private void inkPresenter_MouseLeftButtonDown(object sender, System.Windows.Input.MouseButtonEventArgs e)

{

// Starte mit der Aufzeichnung

inkPresenter.CaptureMouse();

// Merke die Punkte

StylusPointCollection stylusPointCollection = new StylusPointCollection();

// Füge die ersten Punkte hinzu

stylusPointCollection.Add(e.StylusDevice.GetStylusPoints(inkPresenter));

// Erstelle aus den Punkten einen Strich

currentStroke = new Stroke(stylusPointCollection);

// Zeichne den Strich (dieser wird später weiter aktualisiert)

inkPresenter.Strokes.Add(currentStroke);

}

private void inkPresenter_LostMouseCapture(object sender, System.Windows.Input.MouseEventArgs e)

{

// Beende die Aufzeichnung

currentStroke = null;

inkPresenter.ReleaseMouseCapture();

}

private void inkPresenter_MouseMove(object sender, System.Windows.Input.MouseEventArgs e)

{

// Füge dem aktuellen Strich neue Punkte hinzu

if (currentStroke != null) {

currentStroke.StylusPoints.Add(e.StylusDevice.GetStylusPoints(inkPresenter));

}

}

}

}

Natürlich könnte das Aussehen des gezeichneten Striches (Stroke) über dessen Attribute variiert und zum Beispiel mit dem Druck des Stiftes kombiniert werden:

1

| currentStroke.DrawingAttributes.Height = e.StylusDevice.GetStylusPoints(inkPresenter)[0].PressureFactor * 100; |

currentStroke.DrawingAttributes.Height = e.StylusDevice.GetStylusPoints(inkPresenter)[0].PressureFactor * 100;

Wenn man das wie im Beispiel unter http://msdn.microsoft.com/en-us/magazine/cc721604.aspx#id0090072 weitertreibt, dann ist sogar eine Handschriftenerkennung im Browser möglich.